横澤研究室では,前のページでご紹介した二つの現象の関係について研究を行っています。

McGurk効果に表されるような「声(音)の内容に関する視聴覚統合」と

腹話術効果に表されるような「声(音)の発生源に関する視聴覚統合」,

これらはどのように関わっているのでしょうか?

従来の知覚心理学,認知心理学においては,人間の認知処理における

「モジュール性」

(私たちが外界から受け取る情報は,脳の中で様々な要素に分けて分析される,ということ)

がクローズアップされてきました。

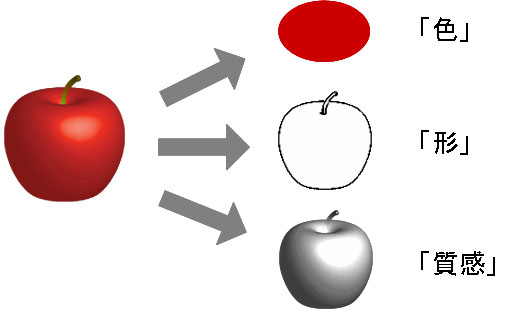

例えば視覚処理を例に挙げると・・・

赤いリンゴを見たとき,私たちの脳においては,

「赤くて」

「丸い形をしていて」

「つるっとした光沢のある」

物体がある,という風に知覚され,リンゴの色や形や質感はそれぞれ別の脳部位で処理されています。

(そのバラバラの処理が後にまとまって「赤くて丸くてつるっと光沢のあるおいしそうなリンゴ」

という風に認識されるのですが,では一度バラバラにした各情報をどのようにしてまとめているのか?

についてはまだ明確な結論が得られていません。)

さて,このように考えると,人間の音声についても脳内では様々な要素に分かれた処理がなされていること

が分かります。

つまり,ある音声が聞こえたとき,その位置・内容は独立に分析されるのです。

これまで,

McGurk効果に表されるような「声(音)の内容に関する視聴覚統合」と

腹話術効果に表されるような「声(音)の発生源に関する視聴覚統合」,

は全く別々の過程だと考えられてきました。

前ページの例のように全く同じ実験材料を用いてこの2つの統合処理をはかることができますが,

これまでの研究では,腹話術効果の大きさは動画を提示するディスプレイと音声を提示するスピーカの間の

距離のみによって,またMcGurk効果の大きさは動画の口の動きや音声の聞き取りやすさ等のみによって決まる,

と考えられてきました(Jones & Jarick, 2006; Radeau, & Bertelson, 1977)。

まとめると,

位置の処理を反映する腹話術効果は視聴覚刺激の位置情報のみから

内容の処理を反映する

McGurk効果は視聴覚刺激の内容の情報のみから

規定されている

ということになります。

ところがここでご紹介したような従来の実験では,常に動画が一つ,音声が一つ,という1ペアの刺激が

用いられていました。

私たちが日常的に暮らしている世界では様々な顔があって(人がいて),様々な声が色々なところから

聞こえるという状況が普通ですから,このような実験では現実世界で我々がどのような認識をしているのか

調べ切れていない可能性があります。

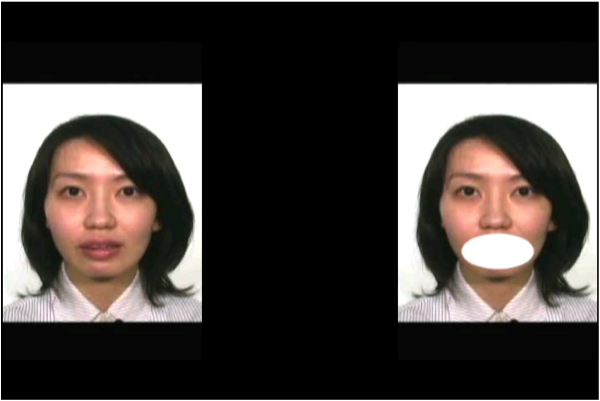

Kanaya & Yokosawa (2011)では,一つの音声に対して2つの顔を提示しました(刺激例↓)。

操作したのは動画と音声の表す音の情報が「同じ音か」「違う音か」という点です。

例えば動画の女性の口元も音声も/pa/と言っていれば,「同じ音」。口元では/pa/と発音しているように

見えるのに音声が/ka/と言っていれば,「違う音」ということになります。

なお,顔は2つですが動画と音声の音韻の関係性を操作するため,片方の口にはマスクをかけてあります。

実験の結果,腹話術効果(=口元が見えている方の顔の方向へ,音源が錯覚された量)は,

動画と音声の表す音の情報が「同じ音」の時のほうが「違う音」の時よりも大きくなりました。

このことは,

「何が?」に関する情報である視聴覚刺激の一致・不一致が「どこに?」に関する

情報である聴覚刺激の位置の処理に影響を与えた,という点で非常におもしろい発見だと考えています。

数々の先行研究では「何が?」と「どこに?」の処理の独立性が主張されてきましたが,今回の実験のように

複数の顔(や声)が同時に存在するような状況では,たった1ペアの刺激を提示するような先行研究で得られて

きたような結果とは少し違った,人間の認知特性が反映されたと考えられます。

人の認知は,どのくらいの刺激(つまり,視覚や聴覚から得る情報)が存在しているのか?

状況がどのくらい複雑なのか?等によって,柔軟にその認知の様式を変えることができるの

かもしれません。

文献

Bertelson, P., & Aschersleben, G. (1998). Automatic visual bias of perceived auditory location. Psychonomic Bulletin and Review, 5, 482-489.

Jack, C. E., & Thurlow, W. R. (1973). Effects of degree of visual association and angle of displacement on the "ventriloquism" effect. Perceptual and Motor Skills, 37, 967-979.

Jones, A., & Jarick, M. (2006). Multisensory integration of speech signals: the relationship between space and time. Experimental Brain Research, 174, 588?594

McGurk, H., & MacDonald, J. (1976). Hearing lips and seeing voices. Nature, 264, 746-748.

Radeau, M., & Bertelson, P. (1977). Adaptation to auditory-visual discordance and ventriloquism in semirealistic situations. Perception & Psychophysics, 22, 137-146.

Kanaya, S. & Yokosawa, K.(2011). Perceptual congruency of audio-visual speech affects ventriloquism with bilateral visual stimuli, Psychonomic

Bulletin & Review, 18, 1, 123-128.